Transformer作者初创重磅发布Transformer²,AI模型活了,动态调整自己权重 自适应智能新篇章

从章鱼通过改变皮肤颜色融入周围环境,到人类大脑在受伤后重新连接神经网络,这些都体现了“物竞天择,适者生存”的道理。然而,对于大型语言模型(LLM)来说,想要加入哪怕只是一句话的新知识,都需要再训练一次。

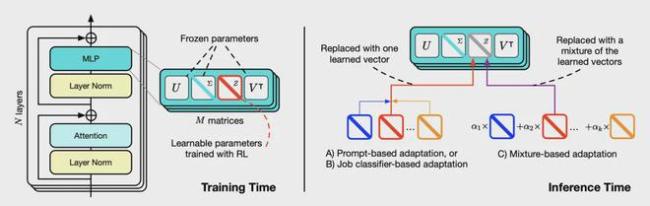

针对这一挑战,Sakana AI的研究团队提出了一种新方法——Transformer²。这种方法可以通过实时选择性地调整权重矩阵中的单一组件,使LLM能够适应未见过的任务。传统上,LLM的后训练需要一次全面的训练来优化模型,使其具备广泛的能力。但实际上,这种一次性微调框架很难实现,因为后训练需要大量资源,导致计算成本和训练时间显著增加。此外,当引入更多样化的数据时,难以同时克服过拟合和任务干扰。

相比之下,自适应模型提供了一种更灵活高效的方法。与其一次性训练LLM来应对所有任务,不如开发专家模块,根据需求将其离线开发并增强到基础LLM中。但是,创建多个专家模块会显著增加需要训练的参数数量,并且容易过拟合,模块之间的组合也不够灵活。

新框架通过有选择性地调整模型权重中的关键组件,让LLM能够实时适应新任务。Transformer²的名字体现了它的两步过程:首先分析传入的任务,理解其需求;然后应用任务专用的适应性调整,生成最佳结果。这种方法在多种任务(如数学、编码、推理和视觉理解)中表现出显著的进步,在效率和特定任务的表现上超越了传统静态方法如LoRA,同时所需的参数大大减少。

人类大脑通过互联的神经通路存储知识并处理信息,而LLM将知识存储在权重矩阵中。这些矩阵构成了LLM的“大脑”,保存了它从训练数据中学习到的核心内容。要理解这个“大脑”并确保它能有效适应新任务,需要深入分析其内部结构。奇异值分解(SVD)提供了宝贵的洞察力,可以将LLM中存储的庞大复杂的知识分解成更小、更有意义且独立的部分。研究发现,增强某些成分的信号,同时抑制其他部分的信号,可以提高LLM在下游任务中的表现。

相关新闻

越有钱死得越快?设定超大胆!《饥饿站台》导演新作《财富流感》发布重磅预告!

由《饥饿站台》导演加尔德·加兹特鲁·乌鲁蒂亚导演并编剧的新作《财富流感》释出新预告及海报!预告中,一种前所未有的新型病毒在富人中流传开来,被病毒感染的人全部先癫狂后死亡,一时间

读者福音这些星座作者是勤奋高产王

金牛座秉持着“今日事今日毕”的原则,他们不认为自己有强迫症,而是一种朴实的态度:既然承诺了每日更新,就要保证内容既高质量又充足,以回馈读者的喜爱。金牛座的这种自律,使他们在编辑眼中成为了理想的合作伙伴

《七夜雪》小说作者是谁 七夜雪结局是什么

《七夜雪》小说作者是谁?七夜雪结局是什么?《七夜雪》小说的作者是沧月。沧月,本名王洋,1979年5月15日出生于浙江台州,中国作家、建筑师,长居西子湖畔。